Видео с ютуба Adam Optimizer

Алгоритм оптимизации Адама (C2W2L08)

Adam Optimizer in 20 min

Оптимизация для глубокого обучения (Momentum, RMSprop, AdaGrad, Adam)

Пошаговое объяснение оптимизатора ADAM — первый и второй моменты, коррекция нулевого смещения

#10. Оптимизаторы градиентных алгоритмов: RMSProp, AdaDelta, Adam, Nadam | Машинное обучение

Who's Adam and What's He Optimizing? | Deep Dive into Optimizers for Machine Learning!

Подробное объяснение оптимизатора Adam | Глубокое обучение

![This Simple Optimizer Is Revolutionizing How We Train AI [Muon]](https://ricktube.ru/thumbnail/bO5nvE289ec/mqdefault.jpg)

This Simple Optimizer Is Revolutionizing How We Train AI [Muon]

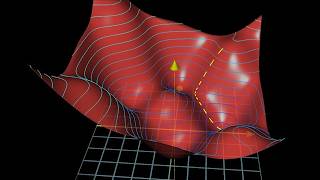

Градиентный спуск, как обучаются нейросети | Глава 2, Глубинное обучение

The ADAM Optimizer, Momentum and RMSProp

Лучшие оптимизаторы для нейронных сетей

Оптимизаторы - ОБЪЯСНЕНИЕ!

5. Adam optimizer in pytorch vs simple grad descent

Tutorial-45:Adam optimizer explained in detail | Simplified | Deep Learning

![Adam Optimizer from scratch | Gradient descent made better | Foundations for ML [Lecture 26]](https://ricktube.ru/thumbnail/XHF2jW_U3iM/mqdefault.jpg)

Adam Optimizer from scratch | Gradient descent made better | Foundations for ML [Lecture 26]

Super Gradient Descent (SuGD) VS Adam #ai #optimization #education

Adam Optimizer from Scratch in Python

Adam optimization ( Adaptive Momentum)